Los científicos están comenzando a ser capaces de interpretar con exactitud las expresiones faciales de los animales y de entender lo que comunican.

Las expresiones faciales proyectan nuestras emociones internas al mundo exterior. Interpretar la cara de otras personas es algo natural y mecánico para la mayoría de nosotros. No hace falta que tu mejor amiga diga nada: con verle esas pequeñas arrugas alrededor de los ojos, las mejillas redondeadas y más elevadas y la comisura de los labios hacia arriba sabes que ha conseguido el ascenso que quería.

¿Qué pasaría si pudiéramos interpretar con la misma facilidad la cara de otros seres vivos? ¿Llegará el día en que podamos poner un teléfono inteligente frente a nuestro gato y saber cómo se siente?

Algunos investigadores están desarrollando sistemas de codificación que permiten interpretar de forma objetiva las expresiones faciales de animales, en lugar de deducir o suponer su significado. Un sistema de codificación describe con precisión cómo cambian los diferentes rasgos faciales cuando un animal siente una emoción concreta, como al entrecerrar los ojos o apretar la boca. Observando fotografías y anotando cuánto cambia cada uno de esos rasgos o “unidades de acción” podemos determinar con qué intensidad se siente una emoción.

Primera frontera: reconocimiento del dolor

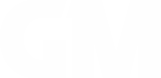

Hasta ahora, solo se han desarrollado científicamente sistemas de codificación del dolor (escalas de gestos) para animales no primates. A pesar de su diferente anatomía, los ratones, las ratas, los conejos, los caballos y las ovejas (incluidos los corderos) ponen una cara de dolor similar: aprietan los ojos, se les abultan o aplanan los carrillos, cambian la posición de las orejas y tensan la boca.

El impulso en el desarrollo de escalas de gestos proviene en gran medida de nuestro deseo y obligación ética de evaluar y mejorar el bienestar de los animales que se utilizan en laboratorios o para la alimentación.

Queremos conseguir una manera de averiguar con precisión y fiabilidad cómo se siente un animal con solo mirarlo, en lugar de tener que extraerle sangre para realizar pruebas o monitorizar su frecuencia cardíaca. Al conocer su estado emocional, podemos ayudarle a reducir su dolor, cansancio o miedo e, idealmente, fomentar su alegría.

Es probable que los animales, sobre todo los sociales, hayan desarrollado expresiones faciales por la misma razón que nosotros: para comunicarse entre ellos o, en el caso de los perros, con nosotros.

Especialmente para las presas, las sutiles señales que otros miembros de su grupo pueden percibir (pero no los depredadores) son útiles para su seguridad, por ejemplo. Una señal de comportamiento de dolor puede generar la ayuda o el consuelo de otros miembros del grupo, o bien servir de advertencia para no acercarse a la fuente del dolor.

Si podemos descifrar los gestos, en teoría también deberíamos poder comprender las expresiones faciales provocadas por otras emociones como la alegría o la tristeza. También es probable que queramos entender las expresiones faciales de los animales más cercanos a nuestros corazones: nuestras mascotas.

Una aplicación en el móvil para las emociones animales

Algún día, los dueños de mascotas, los ganaderos y los veterinarios podrían poner un teléfono inteligente delante de un perro, de una oveja o de un gato y hacer que una aplicación les diga qué emoción concreta está sintiendo el animal.

Sin embargo, conseguir un sistema de identificación de emociones automatizado requiere muchos pasos. El primero es definir las emociones de una manera comprobable y no específica por especie.

El segundo es recopilar datos descriptivos de referencia sobre la expresión emocional en un entorno controlado y experimental. Una forma de hacerlo podría ser hacer que los animales experimenten situaciones que provoquen una emoción concreta y ver cómo cambian los patrones cerebrales, la fisiología, el comportamiento y el rostro. Cualquier cambio debería ocurrir con la suficiente fiabilidad como para poder denominarlo “expresión facial”.

Después de recopilar estos datos, deberíamos convertir esa información científica en un sistema tecnológico automatizado. El sistema debería poder extraer de una imagen las unidades de acción facial claves y determinar en qué medida esos rasgos difieren de la expresión neutra de referencia.Ya contamos con algunos indicios que podemos seguir: cuando los caballos están deprimidos cierran los ojos, incluso cuando no están durmiendo. Cuando las vacas tienen miedo aplanan y agachan las orejas sobre la cabeza y abren mucho los ojos. Cuando las ratas están contentas tienen las orejas más abiertas y hacia delante y de un color más rosado.

El sistema también debería poder resolver las diferencias individuales en los rasgos faciales, así como las sutiles diferencias en la forma en que cada sujeto expresa una emoción. El proceso de extracción y cálculo de los rasgos se complica o falla cuando un rostro está mal iluminado, en ángulo o parcialmente cubierto.

Aunque estamos progresando en la identificación automatizada de la expresión facial humana, todavía nos queda mucho camino en lo referido a los animales. Un objetivo más realista a corto plazo sería entender mejor qué emociones expresan los animales no humanos y cómo lo hacen. Puede que las respuestas nos estén mirando directamente a la cara.

*La versión original de este artículo fue publicada siendo la autora investigadora postdoctoral en la Universidad de Alberta.![]()

Mirjam Guesgen*, Freelance Science Writer, University of Alberta

Este artículo fue publicado originalmente en The Conversation. Lea el original.